研究所动态

我所一篇离线强化学习智能决策技术的文章被国际顶级会议ICLR 2026接收

发布时间:2026年2月6日

本篇工作由我所博士生成鹏和武志昊老师、林友芳老师以及清华大学智能产业研究院詹仙园老师合作完成。

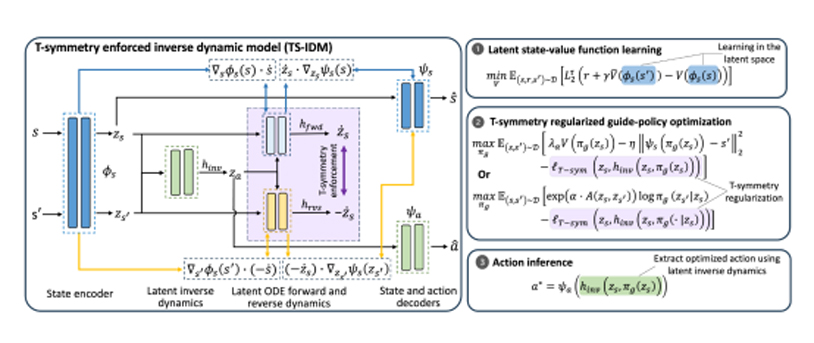

近年来,离线强化学习已取得显著进展。然而,现有方法通常依赖大量训练数据才能获得理想性能,且由于采用基于数据的保守正则化策略,其分布外泛化能力有限。这在许多实际应用场景中严重制约了离线强化学习的实用性,因为现实场景中可用数据往往十分稀缺。本研究提出TELS算法,这是一种具备极高样本效率的离线强化学习方法,能够在由动力学系统的时间反演对称性调控的紧凑潜在空间中实现状态拼接。具体而言,我们引入具有时间反演对称性的逆动力学模型,通过该模型可推导出具有良好调控特性的潜在状态表征,从而极大促进分布外泛化能力。随后,引导策略可完全在潜在空间中被学习,以优化奖励最大化的下一状态,这规避了多数离线强化学习方法中采用的保守动作级行为正则化。最后,优化的动作可通过已学习的TS-IDM模型与引导策略生成的优化潜在状态共同推导得出。我们在D4RL基准测试任务和真实工业控制测试环境中进行了全面实验,结果表明TELS在样本效率和分布外泛化性能上均表现优异,在一系列具有挑战性的小样本任务中显著超越现有离线强化学习方法。